Priyanjali Gupta, estudiante de tercer año de informática del Instituto de Tecnología Vellore (VIT) de Tamil Nadu, se especializa en ciencia de datos y recibió el desafío de su madre el año pasado “para hacer algo ahora que está estudiando ingeniería“.

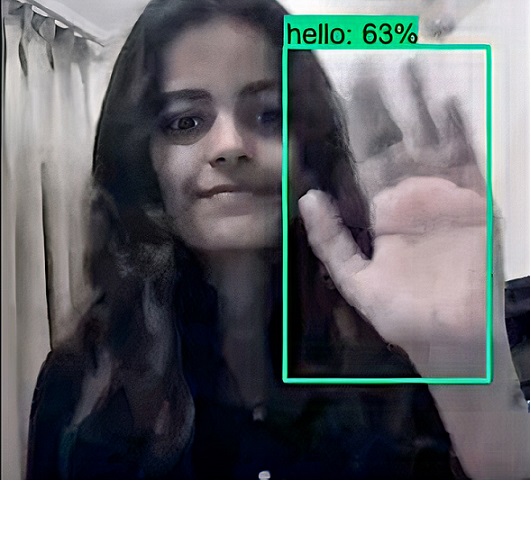

Entonces, creó un modelo impulsado por inteligencia artificial capaz de traducir el lenguaje de señas estadounidense al inglés en tiempo real.

Este nuevo modelo se desarrolló utilizando la API de detección de objetos de Tensorflow.

El conjunto de datos utilizado se genera manualmente ejecutando el archivo Image Collection Python que recopila imágenes de su cámara web para todos los signos mencionados a continuación en el lenguaje de señas estadounidense: Hola, te amo, gracias, por favor, sí y no.

En otras palabras , en lugar de rastrear toda la transmisión de video de la cámara web de un usuario, se enfoca principalmente en fotogramas individuales.

¿Que sigue? Gupta está trabajando actualmente en la detección de video, pero eso requeriría el uso de redes de memoria a largo plazo (LSTM).

“El conjunto de datos se crea manualmente con una cámara web de computadora y se le dan anotaciones.

El modelo, por ahora, se entrena en fotogramas individuales.

Para detectar videos, el modelo debe entrenarse en varios fotogramas para los que es probable que use LSTM.

Actualmente estoy investigando al respecto.

Los investigadores y desarrolladores están haciendo todo lo posible para encontrar una solución que se pueda implementar.

Sin embargo, creo que el primer paso sería normalizar los lenguajes de señas y otros modos de comunicación con las personas especialmente capacitadas y trabajar para cerrar la brecha de comunicación”, dijo Gupta.

Fuente: YouTube