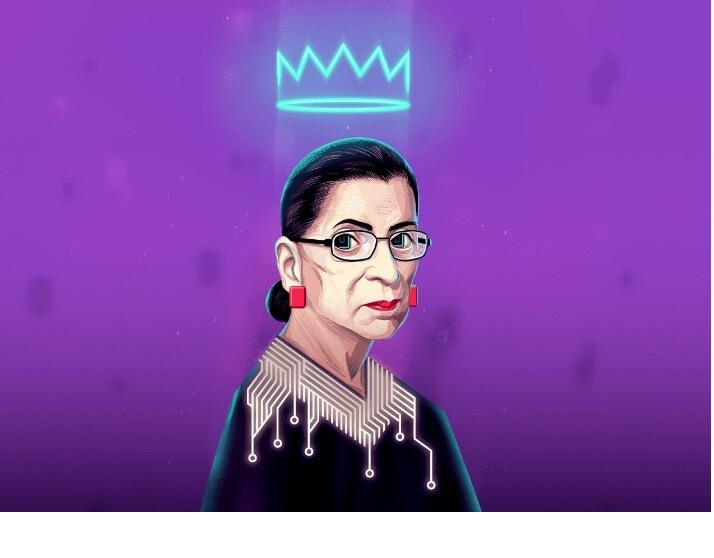

Ruth Bader Ginsburg era una de las juezas más reconocidas del Supremo de los Estados Unidos, con más de 27 años de experiencia.

Ahora todo ese trabajo ha sido condensado en una inteligencia artificial.

Una empresa israelí, AI21 Labs, ha creado una IA basada en las respuestas de la jueza Ginsburg para ofrecer un chat que entiende preguntas del ámbito legal y responde si está bien o mal.

Respuestas de una jueza del Supremo en pocos segundos.

Para probar la IA podemos acceder a la web dedicada del programa Jurassic-1, el experimento donde se han repasado las opiniones, entrevistas y sentencias de la jueza.

En total, más de 600.000 palabras del ámbito legal se han utilizado para entrenar a esta IA.

Todas ellas provienen de una de las juezas con más renombre, que falleció hace un par de años.

En un recuadro, podemos escribir cualquier cosa a la IA, siempre que esté en inglés y se pueda responder con sí, no o un quizás.

La IA además de elegir una de las tres opciones, argumentará ligeramente la respuesta.

Como ocurre con los distintos desarrollos de inteligencia artificial, por muy adecuadas que parezcan las respuestas, todavía estarán muy lejos de equipararse a las reflexiones de la jueza original, en este caso.

Emily Bender, profesora de la Universidad de Washington explica que “puede devolver palabras y el estilo de ellas se basará en el texto que introdujeron, pero no está razonando“.

La IA ya se ha implantado en la Justicia, pero por el momento como apoyo.

Esta herramienta basada en la jueza Ginsburg es llamativa y es uno de los trabajos más modernos, pero el uso de algoritmos e IA en la Justicia no es nuevo.

Desde hace tiempo la administración de Justicia utiliza algoritmos para calcular la probabilidad de reincidencia o para recuperar información de grandes bases de datos, pero se ha quedado ahí.

“En la medida en que un algoritmo no tiene por sí mismo ningún elemento de subjetividad, sino que se limita a ejecutar una serie de órdenes, se elimina la posibilidad de interferencia de prejuicios o creencias que puedan alterar la aplicación mecánica de las normas“, explica David Martínez, profesor de derecho de la UOC.

Los robots se postulan como la solución ante la diferencia de criterios de los jueces.

Al no verse afectados por las emociones, los algoritmos prometen una mayor objetividad.

Sin embargo, como ya se ha mostrado en numerosas ocasiones, tampoco están libres de sesgos.

“Un algoritmo no es capaz de detectar las razones por las cuales se producen las conductas humanas“, expone a RTVE el magistrado gallego, Luis Villares.

Esa falta de capacidad para entender las emociones juega también un papel negativo a la hora de establecer una sentencia.

“La IA devuelve horas de trabajo a los magistrados y gestores que pueden ser invertidas en otras tareas, como valorar con más minuciosidad las pruebas“, expone Antonio del Moral, magistrado del Tribunal Supremo.

Sin embargo, opina que “la IA no puede sustituir a los jueces, la justicia, por definición, es humana e imperfecta, lo cual asumimos.

El razonamiento judicial no se puede meter en unos moldes estandarizados porque cada ciudadano merece una solución personal“.

Fuente: Jurassic-1