Meta ha desarrollado un motor de generación de imágenes de inteligencia artificial, que espera ayude a construir mundos inmersivos en Metaverse y crear arte digital de alta calidad.

Mucho trabajo para crear una imagen basada solo en la frase, “hay un caballo en el hospital”, cuando se usa una IA de generación.

Primero, la frase en sí se alimenta a través de un modelo transformador, una red neuronal que analiza las palabras de la oración y desarrolla una comprensión contextual de su relación entre sí.

Una vez que capta la esencia de lo que el usuario está describiendo, la IA sintetizará una nueva imagen utilizando un conjunto de GAN (redes antagónicas generativas).

Gracias a los esfuerzos de los últimos años para entrenar modelos ML en conjuntos de imágenes de alta definición cada vez más expansivos con descripciones de texto bien seleccionadas, las IA de última generación pueden crear imágenes fotorrealistas de la mayoría de las tonterías que les das.

El proceso de creación específico difiere entre las IA.

Por ejemplo, Imagen de Google utiliza un modelo de difusión, “que aprende a convertir un patrón de puntos aleatorios en imágenes“.

“Estas imágenes comienzan primero como de baja resolución y luego aumentan progresivamente en resolución”.

Parti AI de Google, por otro lado, “primero convierte una colección de imágenes en una secuencia de entradas de código, similar a las piezas de un rompecabezas.

Luego, un mensaje de texto dado se traduce en estas entradas de código y se crea una nueva imagen”.

Si bien estos sistemas pueden crear casi cualquier cosa que se les describa, el usuario no tiene ningún control sobre los aspectos específicos de la imagen de salida.

“Para darse cuenta del potencial de la IA para impulsar la expresión creativa”, declaró el CEO de Meta, Mark Zuckerberg “las personas deberían poder moldear y controlar el contenido que genera un sistema”.

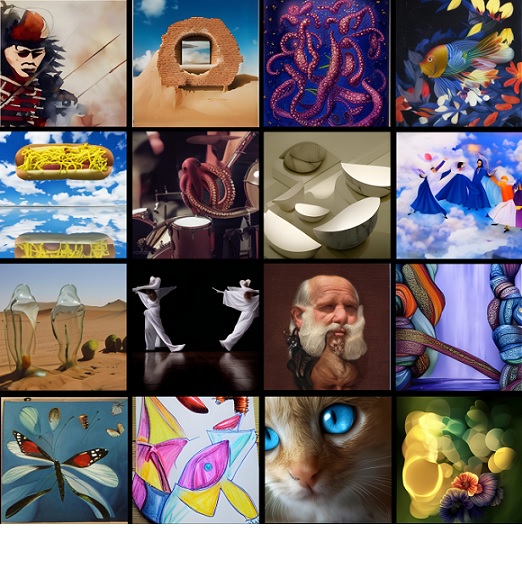

El “concepto de investigación exploratoria de IA” de la compañía, denominado Make-A-Scene, hace exactamente eso al incorporar bocetos creados por el usuario a su generación de imágenes basadas en texto, generando una imagen de 2048 x 2048 pixeles.

Esta combinación le permite al usuario no solo describir lo que quiere en la imagen, sino también dictar la composición general de la imagen.

“Demuestra cómo las personas pueden usar texto y dibujos simples para transmitir su visión con mayor especificidad, usando una variedad de elementos, formas, arreglos, profundidad, composiciones y estructuras”, dijo Zuckerberg.

En las pruebas, un panel de evaluadores humanos eligió abrumadoramente la imagen de texto y boceto en lugar de la imagen de solo texto por estar mejor alineada con el boceto original (99,54 por ciento de las veces) y mejor alineada con la descripción del texto original el 66 por ciento de las veces. .

Para desarrollar aún más la tecnología, Meta ha compartido su demostración Make-A-Scene con destacados artistas de inteligencia artificial, incluidos Sofia Crespo, Scott Eaton, Alexander Reben y Refik Anadol, quienes utilizarán el sistema y brindarán comentarios.

No se sabe cuándo la IA estará disponible para el público.

Fuente: arXiv