Una interfaz cerebro-computador traduce en palabras las señales neuronales que controlan los labios, la lengua y la mandíbula.

El hallazgo podría ayudar a personas que han perdido el habla por enfermedades degenerativas.

El genial físico británico Stephen Hawking dependía de un dispositivo para comunicarse a causa de la esclerosis lateral amiotrófica (ELA) que padecía.

La traqueotomía a la que fue sometido lo dejó mudo, por lo que, con el cuerpo paralizado, utilizaba la mejilla para enviar comandos a un teclado virtual que luego eran transformados en sonido por un sintetizador de voz.

Como el científico, muchas personas que han sufrido devastadores accidentes cerebrovasculares, trastornos neurológicos e incluso cáncer dependen de dispositivos semejantes para contactar con el mundo que los rodea.

Estas tecnologías pueden resultar de gran ayuda, pero son mucho más lentas que la velocidad normal del habla humana: generalmente, permiten emitir ocho palabras por minuto, lo que está muy lejos de la comunicación fluida natural, con unas 150 palabras por minuto como promedio.

Pero quizás haya una forma de acelerar el proceso y devolver la voz a quienes la han perdido.

Científicos estadounidenses de la Universidad de California en San Francisco y la de Emory en Atlanta han desarrollado una nueva interfaz cerebro-computador capaz de reproducir frases enteras directamente del pensamiento.

Y lo han hecho gracias al «deep learning» (aprendizaje profundo), el sofisticado campo de inteligencia artificial que imita la manera en que aprende el cerebro humano.

No es la primera vez que se da a conocer una máquina para «leer la mente» con una tecnología similar, pero en la mayoría de los casos solo han logrado captar palabras monosilábicas sueltas.

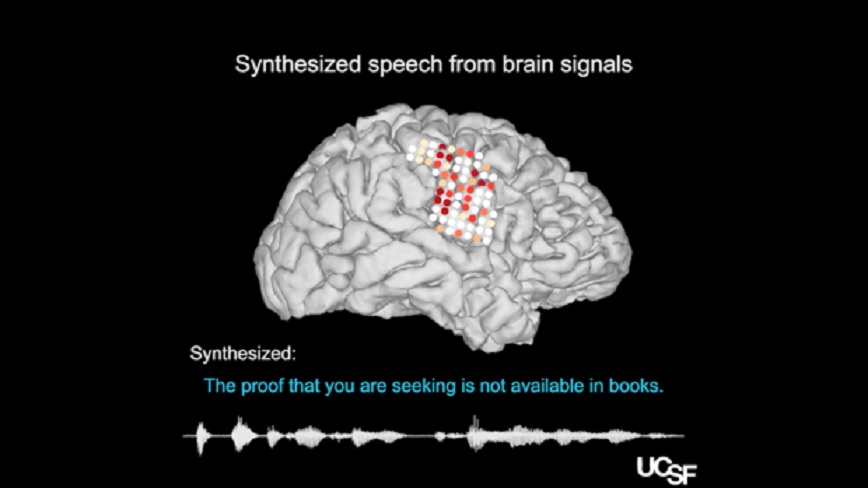

Según explica en la revista «Nature», este equipo multidisciplinar de neurocientíficos, ingenieros, lingüistas e informáticos ha desarrollado un decodificador que puede transformar la actividad cerebral en lenguaje utilizando las señales neuronales que controlan los labios, la lengua, la laringe y la mandíbula.

Para empezar, los investigadores registraron con electrodos intracraneales la actividad cortical del cerebro de cinco voluntarios mientras pronunciaban varios cientos de oraciones en voz alta, frases sencillas en inglés escogidas por su fonética como «The proof you are seeking is not avalaible in books» (La prueba que estás buscando no está disponible en los libros) o «Ship building is a most fascinating process» (La construcción de barcos es un proceso fascinante).

Para reconstruir el habla, en vez de transformar las señales cerebrales directamente en señales de audio, lo hicieron en dos etapas.

En la primera, los autores decodificaron las señales cerebrales responsables de los movimientos individuales del tracto vocal.

Solo entonces, transformaron los movimientos decodificados en oraciones habladas.

En las pruebas, los oyentes pudieron identificar y transcribir fácilmente el discurso sintetizado.

En pruebas separadas, se pidió a un participante que dijera las oraciones y luego las imitara, haciendo los mismos movimientos articulatorios pero sin emitir sonido alguno.

Si bien el habla imitada era imperfecta, las frases podían ser reconocibles.

Se reclutó un panel de varios cientos de hablantes nativos de inglés para descifrar el discurso sintetizado.

Se les dio a los panelistas un grupo de palabras para elegir y se les dijo que seleccionaran la mejor coincidencia.

En las pruebas, alrededor del 70 por ciento de las palabras se transcribieron correctamente.

De manera alentadora, muchas de las palabras perdidas fueron aproximaciones cercanas, como confundir “roedor” con “conejo”, como ejemplo.

Una limitación importante de este tracto vocal virtual es la necesidad de cirugía cerebral e implantes craneales para personalizar el sistema para cada persona.

En el futuro previsible, esto tendrá que seguir siendo invasivo, ya que actualmente no existen dispositivos tecnológicos capaces de recopilar la resolución requerida fuera del cerebro.

«La conclusión principal de nuestro estudio demuestra que es posible reconstruir el habla a partir de la actividad cerebral», asegura Edward Chang, neurocientífico de la Universidad de California en San Francisco y coautor del trabajo.

En un artículo adjunto al estudio en «Nature», Chethan Pandarinath y Yahia Ali, ambos del departamento de Ingeniería Biomédica en la Universidad de Emory, señalan que los autores han logrado una prueba de concepto convincente, aunque aún quedan muchos desafíos antes de que pueda convertirse en una interfaz cerebro-computadora clínicamente viable.

La inteligibilidad del discurso reconstruido es aún mucho menor que la del habla natural, por lo que está por ver si la recopilación de conjuntos de datos más grandes y el desarrollo computacional pueden incluir mejoras.

En todo caso, la interfaz podría ser un primer paso para que las personas que han perdido el habla debido a enfermedades degenerativas puedan recuperarla.