CM3leon es una inteligencia artificial generativa creada por Meta. Se trata de una IA capaz de trabajar en ambas direcciones, tanto generando imágenes a partir de texto como texto a partir de imágenes.

CM3leon es un modelo de lenguaje de inteligencia artificial generativa, lo que quiere decir que es capaz de generar contenido nuevo a partir de las órdenes que le demos.

Ha sido creada por Meta, la empresa que engloba aplicaciones como Facebook, Instagram o WhatsApp.

Uno de los principales atractivos de este modelo de lenguaje es que es multimodal, lo que quiere decir que no tiene un objetivo concreto, sino que puede hacer varias cosas.

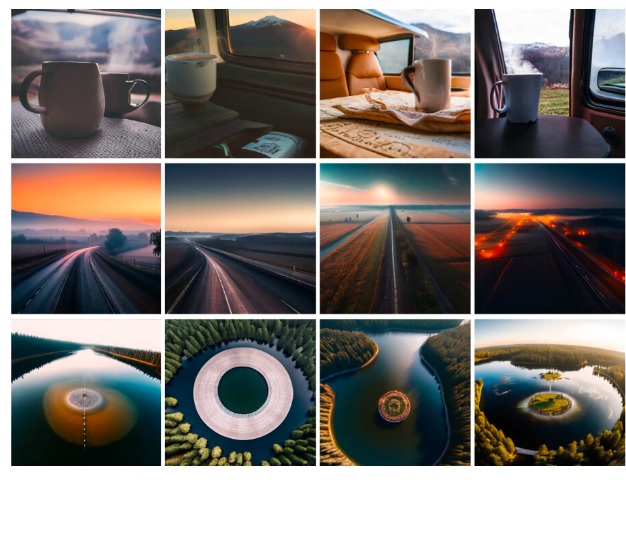

Por ejemplo, puedes generar imágenes a partir de texto y también lo contrario, generar textos a partir de imágenes.

Esto permite que la IA de Meta sea más versatil que otras dedicadas solo a generar textos o a generar imágenes.

Por ejemplo, puede describir una imagen utilizando texto, y responder las preguntas que le hagas sobre una imagen.

También puede interpretar la estructura o el aspecto de una imagen para saber que haces modificaciones coherentes con su contexto.

Además de esto, el modelo de CM3leon también puede editar una imagen que le des a partir de un prompt textual.

Puedes subir una imagen y decirle cómo quieres que la modifique, todo ello con acabados de alta resolución.

La otra gran ventaja de este lenguaje es que promete utilizar cinco veces menos recursos computacionales que otros sistemas de inteligencia artificial.

CM3Leon utiliza en su arquitectura un transformador de sólo descodificador, algo similar a lo que utilizan otros modelos consolidados basados en el texto.

Pero la diferencia es que es capaz de introducir y generar tanto texto como imágenes, permitiéndole ser más versátil y realizar más tareas.

Meta asegura que su modelo multimodal es el primero entrenado con una receta adaptada de los modelos de solo texto.

Para eso han utilizado una primera etapa de preentrenamiento a gran escape aumentada por recuperación, y una segunda etapa de ajuste fino supervisado multitarea.

Con esta receta de entrenamiento, Meta dice que ha conseguido producir un modelo sólido demostrando que los transformadores basados en tokenizadores pueden entrenarse con la misma eficacia que los modelos generativos basados en la difusión.

Para entrenarse se ha utilizado cinco veces menos computación, pero a pesar de eso ha conseguido grandes resultados generando imágenes a partir de texto.

Lo definen como un modelo causal enmascarado mixto-modal (CM3) por poder generar secuencias de texto e imágenes condicionadas a secuencias arbitrarias de otros contenidos de imagen y texto.

Meta también ha aplicado un ajuste de instrucciones multitarea a gran escala para generar imágenes de texto, y también dicen haber conseguido mejorar muchísimo la creación de pies de foto o responder a preguntas visuales mediante sus capacidades de reconocer lo que hay en la imagen.

De momento Meta solo ha presentado este modelo y ha descrito lo que es capaz de hacer, pero todavía no ha dicho nada sobre un posible lanzamiento para el público masivo.

Fuente: Meta