Suturar a un paciente después de una cirugía es una tarea vital pero monótona para los médicos, que a menudo requiere que repita los mismos movimientos simples una y otra vez cientos de veces.

Pero gracias a un esfuerzo de colaboración entre Intel y la Universidad de California, Berkeley, los cirujanos del mañana podrían descargar ese trabajo duro a los robots para sutura automática.

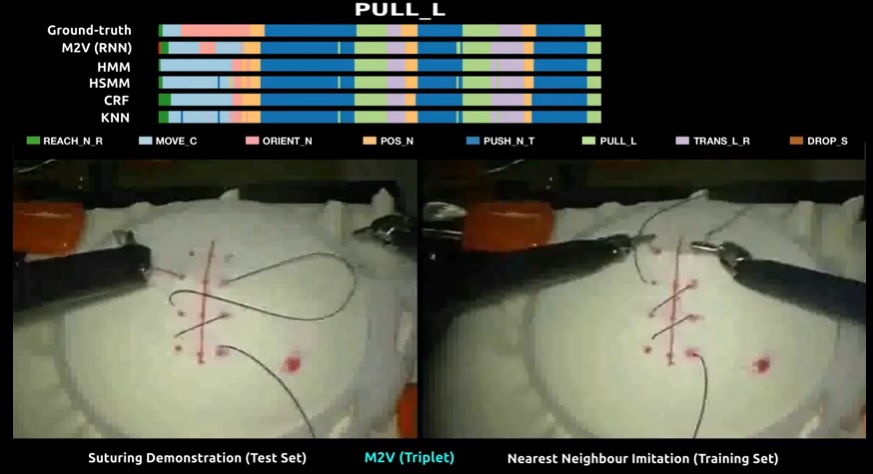

El equipo de UC Berkeley, dirigido por el Dr. Ajay Tanwani, ha desarrollado un sistema de aprendizaje profundo de IA semi-supervisado, denominado Motion2Vec.

Este sistema está diseñado para ver videos quirúrgicos públicos realizados por médicos reales, desglosar los movimientos del médico al suturar (inserción y extracción de la aguja) y luego imitarlos con un alto grado de precisión.

“Hay mucho atractivo en aprender de las observaciones visuales, en comparación con las interfaces tradicionales para aprender de forma estática o aprender de trayectorias [que imitan], debido a la gran cantidad de contenido de información disponible en los videos existentes“, dijo Tanwani a Engadget.

Cuando se trata de enseñar robots, una imagen, aparentemente, vale más que mil palabras.

“YouTube obtiene 500 horas de material nuevo cada minuto. Es un repositorio increíble, un conjunto de datos“, agregó el Dr. Ken Goldberg, que dirige el laboratorio de UC Berkeley y asesoró al equipo de Tanwani en este estudio.

“Cualquier humano puede ver casi cualquiera de esos videos y darle sentido, pero un robot actualmente no puede, simplemente lo ven como una secuencia de pixeles.

Entonces, el objetivo de este trabajo es tratar de dar sentido a esos pixeles.

Eso es mirar el video, analizarlo y … ser capaz de segmentar los videos en secuencias significativas“.

Para hacer esto, el equipo aprovechó una red siamesa para entrenar a su IA.

Tanwani explicó que las redes siamesas están construidas para aprender las funciones de distancia a partir de datos no supervisados o débilmente supervisados.

“La idea aquí es que se desea producir la gran cantidad de datos que se encuentran en videos recombinantes y comprimirlos en una variedad de baja dimensión“, dijo.

“Las redes siamesas se utilizan para aprender las funciones de distancia dentro de esta variedad“.

Básicamente, estas redes pueden clasificar el grado de similitud entre dos entradas, por lo que a menudo se usan para tareas de reconocimiento de imágenes, como hacer coincidir las imágenes de vigilancia de una persona con su foto de licencia de conducir.

En este caso, sin embargo, el equipo está utilizando la red para hacer coincidir la entrada de video de lo que están haciendo los brazos manipuladores con el video existente de un médico humano haciendo los mismos movimientos.

El objetivo aquí es elevar el rendimiento del robot a niveles casi humanos.

Y dado que el sistema se basa en una estructura de aprendizaje semi-supervisada, el equipo necesitó solo 78 videos de la base de datos JIGSAWS para entrenar a su IA para realizar su tarea con una precisión de segmentación del 85.5 por ciento y un error promedio de 0.94 centímetros en la precisión de la focalización.

Pasarán años antes de que este tipo de tecnologías lleguen a quirófanos reales, pero Tanwani cree que una vez que lo hagan, las IA quirúrgicas actuarán de manera muy similar al Driver Assist en los autos semiautónomos de hoy.

No reemplazarán a los cirujanos humanos, sino que aumentarán su rendimiento asumiendo tareas repetitivas de bajo nivel.

El sistema Motion2Vec no es solo para suturar.

Dados los datos de entrenamiento adecuados, la IA podría eventualmente encargarse de una serie de tareas, como el desbridamiento (recoger carne muerta y escombros de una herida), pero no espere que realice su próxima apendicectomía.

“Todavía no estamos allí, pero hacia lo que nos estamos moviendo es la capacidad de un cirujano, que estaría observando el sistema, indicando dónde quieren una fila de suturas, transmitiendo que quieren seis suturas por encima“, dijo Goldberg.

“Entonces el robot esencialmente comenzaría a hacer eso y el cirujano … podría relajarse un poco para poder descansar más y concentrarse en partes más complejas o matizadas de la cirugía“.

“Creemos que eso ayudaría a los cirujanos a enfocar productivamente su tiempo en la realización de tareas más complicadas“, agregó Tanwani, “y usar la tecnología para ayudarlos a ocuparse de la rutina mundana“.

Fuente: Engadget