Un grupo de investigación de la Universidad Autónoma de Madrid (UAM) en España ha desarrollado un nuevo sistema de aprendizaje automático que permite controlar factores sensibles que intervienen en la toma de decisiones de los sistemas de reconocimiento biométrico.

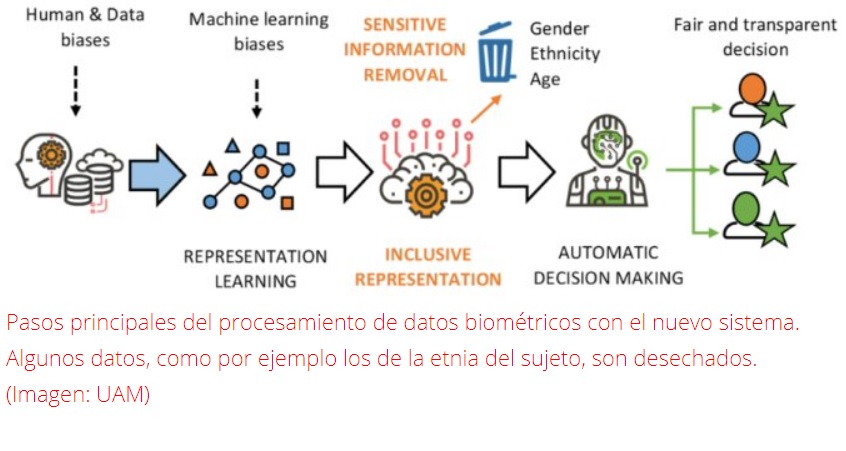

Conocido como SensitiveNets, este método se basa en el uso de redes de aprendizaje profundo entrenadas para eliminar información sensible, como son los factores de género, raza o edad, de las representaciones generadas por estos sistemas.

De esta manera, transforma el aprendizaje automático tradicional para asegurar justicia y transparencia en la toma de decisiones de los algoritmos, a través de la eliminación de los sesgos introducidos por humanos y por procesos automáticos carentes de ética.

“Vivimos en una sociedad con una gran diversidad y, gracias a la tecnología SensitiveNets, podemos desarrollar algoritmos más justos e igualitarios que permiten garantizar el derecho fundamental de todo ciudadano a no ser discriminado por razones de etnia, género u otras”, explica Aythami Morales, principal inventor del método patentado por el grupo de investigación “Biometrics and Data Pattern Analytics (BiDA) Lab”, de la Escuela Politécnica Superior de la UAM.

El desarrollo de esta tecnología surge ante la nueva regulación europea sobre protección de datos y la necesidad de desarrollar una nueva generación de sistemas entrenados en la diversidad y en la protección de los usuarios ante la discriminación algorítmica.

Fuente: Noticias de la Ciencia