El modelo cuenta con 70.000 millones de parámetros. Puntúa más alto que GPT-3.5 y se acerca de GPT-4.5 en los benchmarks de programación

Programar jamás fue tan fácil. Los modelos de IA generativa que actúan como asistentes de los desarrolladores siguen avanzando sin parar, y tras la aparición de plataformas como GitHub Copilot han empezado a surgir más y más alternativas.

La última, desarrollada por Meta, es especialmente prometedora por un factor clave: su licencia Open Source —más o menos— permite usarla gratuitamente.

En Meta siguen avanzando en el desarrollo de modelos de IA generativa.

El último de ellos es Code Llama 70B, que según ellos es su modelo de IA generadora de código “más grande y que mejor se comporta”.

Es una evolución del modelo que apareció en agosto de 2023.

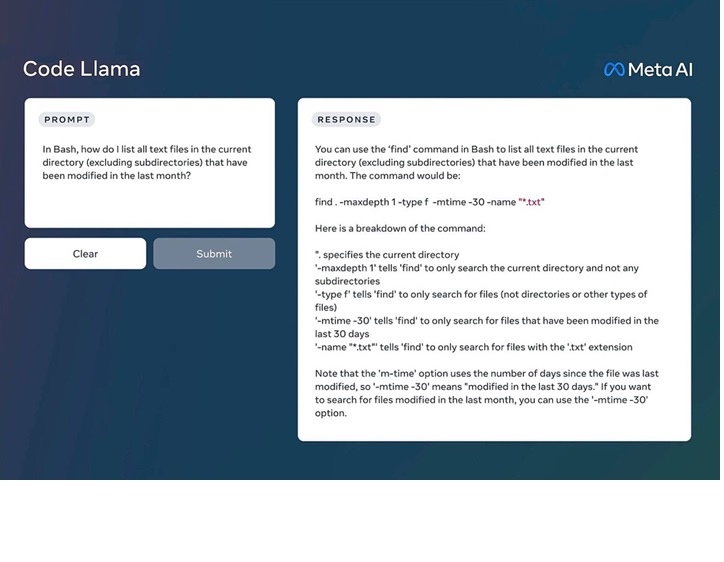

Este gran modelo de lenguaje (LLM) permite que mediante prompts de texto podamos generar código de todo tipo.

Según los responsables de Meta, “Code Llama tiene el potencial para ser usado como una herramienta educativa y de productividad para ayudar a los programadores a escribir software más robusto y bien documentado“.

El modelo es una versión especializada de Llama 2 (que compite con GPT-3.5 y GPT-4) que se creó entrenando este último modelo de forma específica con repositorios de código.

Code Llama 70B puede generar tanto código como lenguaje natural sobre el código —por ejemplo, para explicar qué hace cierta función— y puede ser utilizado tanto para completar el desarrollo de nuestro código como para depurarlo.

Entre los lenguajes soportados están Python, C++, Java, PHP, Typescript (Javascript), C# y Bash.

El modelo está disponible en cuatro tamaños distintos: 7B (pensado para funcionar en local, basta una GPU), 13B, 34B y 70B, y cada uno de estos modelos está entrenado con 500.000 millones de tokens de código, salvo el modelo 70B, que ha sido entrenado con un billón de parámetros.

Estos modelos también aceptan una ventana de contexto enorme de hasta 100.000 tokens.

Un token equivale normalmente a una palabra o pequeño grupo de palabras, así que este sistema es capaz de aceptar una gran cantidad de código para luego trabajar sobre él.

En Meta indican que además del modelo genérico, Code Llama 70B, han añadido “Code Llama – Python” especializado en código en este lenguaje, y también “Code Llama – Instruct“, más orientado a continuar el proceso de entrenamiento del modelo para entender mejor los prompts y lo que el usuario necesita.

Las pruebas que permiten evaluar el rendimiento de Code Llama 70B en el ámbito de la programación demuestran que este modelo se comporta de forma notable.

Han usado tanto HumanEval como Mostly Basic Python Programming, y en ambos el modelo de Meta supera a GPT-3.5 y se acerca al rendimiento de GPT-4, el modelo más capaz de OpenAI.

Como sucede con Llama 2, este modelo también está disponible tanto en plataformas que facilitan su uso directo —Hugging Face es una de las destacadas— como vía su repositorio en GitHub.

Su uso es gratuito y libre tanto con fines personales como comerciales, algo que desde luego plantea una alternativa muy interesante a herramientas de pago similares.

Fuente: GitHub