El fabricante de chips anunció NeMo Guardrails, un software de código abierto que vuelve más confiables y seguros a los chatbots de inteligencia artificial

NVIDIA anunció NeMo Guardrails, un software de código abierto que evitará que las IA generativas como ChatGPT pierdan la cabeza.

La idea del fabricante es establecer una serie de lineamientos para garantizar que las aplicaciones sean precisas y seguras.

Para ello ofrecerán un conjunto de herramientas que permite agregar reglas a las apps impulsadas por modelos de lenguaje extenso (LLM), como GPT-4.

De acuerdo con el fabricante, el software está conformado por kits creados por la comunidad, como LangChain.

Estos contienen plantillas y patrones fáciles de usar, por lo que los desarrolladores podrán definir las acciones deseadas del usuario.

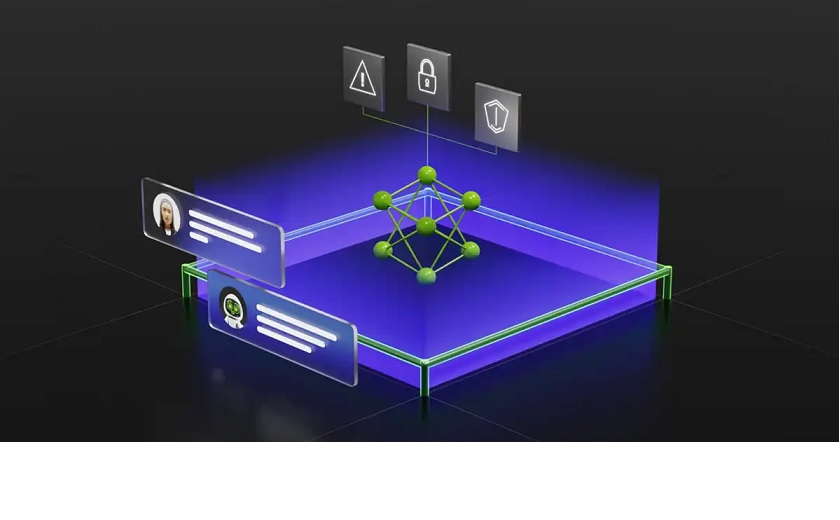

Esto es posible gracias a las barandillas (guardrails), un conjunto de reglas que monitorean y dictan las interacciones que puede tener la persona con una aplicación como ChatGPT.

NeMo Guardrails permite establecer límites que van desde evitar respuestas que se salgan del tópico, restringir conexiones no seguras o prevenir que se ejecute código malicioso.

Estas barandillas se ofrecen en tres niveles:

Barandillas tópicas. Evitan que las aplicaciones se desvíen hacia áreas no deseadas. Por ejemplo, impiden que un chatbot de servicio al cliente responda preguntas sobre el clima.

Barandillas de seguridad. Garantizan que las aplicaciones respondan con información precisa y adecuada. Pueden filtrar el lenguaje no deseado y hacer cumplir que las referencias se hagan solo a fuentes creíbles.

Barandillas de salvaguarda. Restringen las aplicaciones para que hagan conexiones solo con aplicaciones externas de terceros que se sabe que son seguras.

Según NVIDIA, el software es fácil de usar y cualquier desarrollador puede implementar las plantillas en sus chatbots.

Las reglas se crean con pocas líneas de código y se aplican a cualquier aplicación que utilice una biblioteca de Python.

Las medidas de seguridad apuntan a resolver uno de los principales problemas que vemos en chatbots impulsados por IA.

Las barandillas garantizarían que las interacciones no contengan información falsa, contenido inapropiado o respuestas tóxicas.

Está comprobado que ChatGPT suele inventar información y presentarla como un hecho, o en el caso de Bing, enloquecer tras varias consultas.

NeMo Guardrails está basado en Colang, un lenguaje desarrollado por NVIDIA para IA conversacional.

Las barandillas se ubican entre el usuario y la aplicación (ChatGPT), monitoreando la comunicación y aplicando medidas para que el modelo permanezca en el dominio establecido.

Según el fabricante, estas barandillas serían como los límites que definen el ancho de una carretera y que evitan que los vehículos se desvíen.

Las tres categorías operan en diversos niveles.

Por ejemplo, las barandillas tópicas se mantienen enfocadas en un tema y redirigen una conversación cuando se sale de tópico.

Las barandillas de seguridad no solo garantizan respuestas adecuadas o confiables, sino que evitan que los humanos burlen las reglas y obtengan información no autorizada, como lo vimos en los primeros días de Bing.

Por último, las barandillas de salvaguarda tienen como objetivo mantener seguro el sistema ante ataques externos.

Esta categoría evita que el modelo LLM ejecute código malicioso o haga llamadas a una aplicación no autorizada.

Esta categoría será una de las más importantes, ya que los ciberataques contra las IA se volverán más sofisticados a medida que aumente la adopción de esta tecnología.

NVIDIA reveló que NeMo Guardrails estará disponible en GitHub, así como también en la plataforma NVIDIA AI Enterprise.

El software es de código abierto y se apoyará en la comunidad para continuar su desarrollo.

Fuente: NVIDIA